La nVidia del Trillón

“Nunca supe como terminar mi plan de negocios” - Jensen Huang, CEO y Cofundador de Nvidia

Nadie se imagina, y mucho menos planea, una empresa del club de las trillonarias. La naturaleza emergente de la estrategia es aún más evidente en estas compañías. Por eso, la historia de Nvidia, la última de ellas en unirse al club de Apple, Amazon, Microsoft y Google, miembros actuales de este selecto grupo, no es la excepción. Su historia es tan fascinante, como emergente. Es una de muchos planes fallidos, unos pocos hard choices en los que la compañía estuvo en juego, y altas dosis de ambición y foco, con algo de suerte, pues la suerte ayuda a los enfocados (Pasteur decía que ayuda a los preparados). Aquí esta su historia.

El 5 de abril de 1993, en San José, California, alrededor de una mesa de algún Denny’s —el desayunadero gringo de bajo presupuesto por excelencia— se reunieron tres ingenieros electrónicos: Jensen Huang, Chris Malachowsky y Curtis Priem. Dos de ellos venían de Sun Microsystems, la productora de “Workstations”, que era el gran ganador en la computación profesional. Entrando a este segmento con NeXT, donde fracasó, Steve Jobs aprendió cosas que después utilizaría en su retorno a Apple. Sun existía entre el mundo básico del PC, y el mundo de los grandes computadores industriales corporativos como IBM, y fue la compañía más revolucionaria de Silicon Valley entre 1982 y el 2009, cuando fue vendida a Oracle.

Muchos de los antecedentes de Nvidia hay que buscarlos en Sun, compañía que fue pionera en temas de “Workstations” para computación gráfica, incluyendo el embrión de las GUI’s y diseño que los llevó a desarrollar tecnologías fundamentales, pues las vigentes no servían. Éstas hoy se consideran “estándares”, como el uso de UNIX, y fueron los creadores de JAVA, la arquitectura RISC (lenguajes de máquina más eficientes), que era el corazón del desempeño superior de sus “Workstations”.

Por esa vía, además, fue que terminaron anticipando el mundo de arquitecturas de cliente/servidor de alto desempeño, virtualización, servicios en la nube, e incluso la primera red social de desarrolladores. Fueron ellos los pioneros de la arquitectura abierta y los primeros desafiantes al monopolio de Microsoft. En especial fue una compañía integrada de hardware y software. Aunque Sun creció mal, especialmente en el dot-com boom de finales de siglo, y fue eventualmente adquirida, pues nunca se recuperó del guayabo del dot-com, las revoluciones que activó son centrales a la industria informática moderna, y algunos de sus ingenieros continuaron la revolución en otras compañías. La más relevante de ellas: Nvidia.

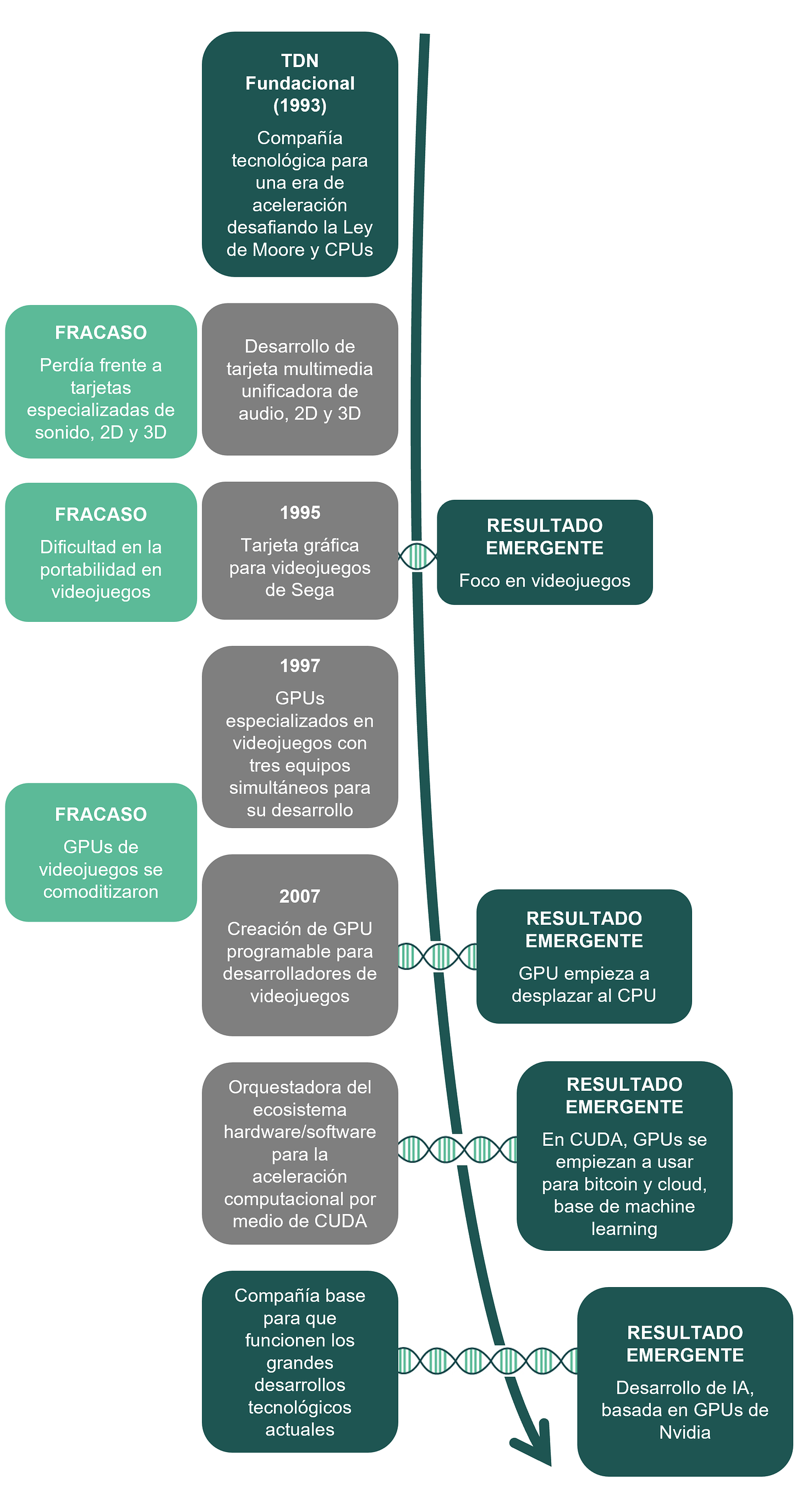

Volviendo al desayunadero, la idea básica que los convocaba —su Teoría del Negocio (TDN) fundacional— era que la siguiente gran revolución tecnológica iba a requerir velocidades de cómputo superiores a las que jamás se iban a conseguir vía el dictum de la Ley de Moore y el CPU. En otras palabras, la Ley de Moore se iba agotar, y con ella la garantía implícita de que los computadores se seguirían doblando en desempeño y reduciendo 50% su costo cada 18 meses. Desafiar esta ley, en la práctica, era desafiar a WINTEL, como ya lo había hecho Sun, que era el co-monopolio sobre el que estaba construida la industria Tech, donde reinaban las dos compañías más valiosas del mundo en ese momento: Microsoft, que hacía el software que se beneficiaba de esta regla; e Intel, que fabricaba los chips en los que ese software corría.

La TDN fundacional, entonces, era una compañía para una era de aceleración computacional, no basada en el CPU y la ley de Moore, de diseño de hardware periférico, con un modelo fabless (sin fábrica), para aplicaciones y usuarios de alta exigencia, que estableciera los estándares para todo tipo de multimedia que era el futuro de la masificación de la computación personal. Ya veremos qué de esta tesis superó el choque con el mercado (realmente la primera parte de la tesis). Lo que sí es claro es que, para variar, a los planes les fue mal.

Plan de una tarjeta para la era multimedia

Convencidos de que el futuro era la multimedia (esa era la idea dominante de la época en los 90’s), y respaldados por Sequoia, uno de los más exitosos VCs del mundo, después de 2 años de desarrollo lanzaron su primer producto: El NV1, una tarjeta de procesamiento de multimedia, diseñada para procesar gráficos 2D/3D y codificación/descodificación de audio, lo cual era una verdadera novedad técnica al unificar todo lo anterior en un sólo chip. Esta joya, creían, estaba destinada a ser la tarjeta multimedia que forjaría el estándar del futuro.

La NV1 terminó perdiendo con las tarjetas especializadas: tanto en la reproducción de audio y el 2D, pues cada una tenían procesamiento más rápido, y en el 3D con el procesamiento renderizado que ofrecían como valor independiente sus competidores.

Nvidia, incluso, mejoró el producto, cuyo resultado fue la NV2, en alianza con Sega —principal competidor de Nintendo en su momento—, pero este intento también fracasó por su dificultad de utilizarse en videojuegos. Así fue como esta idea quedó archivada: la ventaja no estaba en la acumulación de características en una sola tarjeta de procesamiento.

Resultado Emergente: Ganar en el videojuego

Los tiempos difíciles enfocan a las personas y organizaciones. Ese choque inicial con el mercado que derivó en el postmortem de NV1 y NV2, demostró que la idea fundacional de tener todo en una sola tarjeta multimedia era errónea.

La fallida alianza con SEGA, sin embargo, los metió emergentemente al mundo de los videojuegos, donde se conectan altos volúmenes de ventas y complejos desafíos de hardware. Los videojuegos eran un segmento en el que los temas de velocidad de desarrollo, y superioridad funcional en temas como realismo, eran altamente exigentes, así como la vulnerabilidad de la Ley de Moore.

Donde otros veían simple entretenimiento, o un vehículo para corromper la mente de los jóvenes, Nvidia vio un mercado para desarrollar sus capacidades: un mercado de hardware comercial, con pocos jugadores, en el que se disputaba una batalla vanguardista entre desarrolladores y fabricantes de consolas por quién era capaz de producir videojuegos más fotorrealistas y dinámicos. Era la oportunidad emergente que Nvidia estaba manifiestamente destinada a capitalizar.

Tenían, sin embargo, un competidor que había avanzado en esta misma dirección desde mucho antes que Nvidia. 3dfx, con Voodoo Graphics como su producto estelar, ya había logrado altos estándares de renderización 3D, los cuales eran sustancialmente superiores en PCs, con respecto a los tempranos desarrollos de Nvidia.

Del CPU al GPU: La victoria del Paralelismo

Competir en esta cancha obligó a Nvidia no sólo a buscar diseños de computación paralela (al final de esta entrega volveremos sobre esto), sino a construir una organización paralela de desarrollo. Es decir, el límite, más que técnico (como lo predecía la Ley de Moore), era organizacional. Aunque la cima por escalar parecía abrumadora, Nvidia activó tres equipos de desarrollo en paralelo para poder acortar el ciclo de desarrollo de la industria de 18 a 6 meses. Era una apuesta arriesgada: sus costos de desarrollo se dispararon sin tener asegurado el resultado, pero Nvidia confió en su equipo, y en 1997, rápidamente lanzaron RIVA 128, buscando ser relevantes en el mercado, la cual fue la primera GPU (graphics processing unit) enfocada exclusivamente en gráficas 3D. Los GPUs, al menos para esta época, eran los complementos gráficos de los CPUs (los que mencionamos antes como elemento esencial en esta historia). En realidad, el primer desarrollo esencial era ese: ir más allá del CPU, creando una GPU potente.

El aceleramiento organizacional rindió fruto pues en menos de un año, Nvidia actualizó su producto con RIVA TNT, que fue la primera tarjeta de procesamiento que realmente compitió mano a mano con Voodoo Graphics. Con esta victoria, Nvidia además había dado dos golpes con uno: no sólo había empatado en calidad de hardware a 3dfx, sino que también, emergentemente, al enfocarse especialmente en tener un rendimiento superior con su GPU, comenzó a superarlo en su soporte de software, convirtiendo así su propuesta de valor cada vez más valiosa, mientras que 3dfx se volvía irrelevante. Organizada de esta manera, la ventaja de Nvidia se magnificó con el lanzamiento de GEforce, ya una GPU superior en todo, la cual Microsoft, que se estaba aventurando en la industria de videojuegos, decidió utilizar para el diseño del Xbox.

En 2001, 3dfx incapaz de competir con la organización de Nvidia, se declararía en bancarrota. La quiebra de 3dfx libero una gran base de talento. Buena parte de ella fue contratada por Nvidia, y su hambrienta organización paralela de desarrollo en GPU. Otros se fueron a la reconstrucción de AMD, que no solo desafió a Intel por abajo (lo que Nvidia hizo por arriba), sino que será un rival de Nvidia más adelante, pues en estrategia emergente nadie ha ganado ningún juego para siempre.

Todo esto, mientras seguía profundizando su core, al tener cada vez GPUs más superiores en el mercado, lo cual se veía representado en que los videojuegos más vendidos eran co-desarrollos con Nvidia, y sus tarjetas de procesamiento gráfico de hardware eran ya la base tanto del PC, como de Xbox y PlayStation. Los chips de Nvidia estaban en toda consola popular de videojuegos.

Servidores, Nubes y Bitcoins: La Suerte Ayuda a los Enfocados

“Lo que nos trajo hasta acá no nos va a llevar allá”. Con el GPU, Nvidia reinaba en el mundo del procesamiento gráfico de videojuegos. Sin embargo, las gráficas, que habían sido la dimensión de beneficio más importante sobre la que se estaba dando la competencia, empezaban a comoditizarse. Fue a raíz de esto que la necesidad de construir un GPU programable se fue volviendo cada vez más relevante. El GPU programable permitiría que los clientes de Nvidia pudieran tener cada vez más control sobre el desempeño de las GPUs, y una identidad gráfica más única. Buscando que la industria tuviera una competencia más benigna, que hubiera menos convergencia, Nvidia —desde su “core”— empezó a promover una plataforma para GPUs programables.

Este, entonces, es un bello ejemplo de cómo el foco expande oportunidades. En el 2006, Nvidia empezó a expandir las posibilidades de su producto hacia lo que sería una nueva forma de entender el procesamiento de datos. Para ese momento, algunos estudiosos de la arquitectura de cómputo se habían percatado de los posibles beneficios emergentes que traían una GPU: no sólo se prestaba para el procesamiento gráfico como complemento de la CPU, sino que también era útil para todo tipo de cálculos que dependían en gran medida del procesamiento paralelo.

Entre estos visionarios se encontraba Ian Buck, un estudiante de doctorado en Stanford que Nvidia finalmente incorporó para crear una API que fuera fácil de usar, pero también capaz de utilizar de manera efectiva todo el potencial computacional paralelo de las GPUs de Nvidia. Así nació CUDA, la plataforma emergente de cómputo que cambiaría las reglas de la computación y mutaría a Nvidia, trascendiendo a los videojuegos.

El impacto de CUDA, por supuesto, no fue inmediato. Pasarían otros años en los que el foco sería el desarrollo de la GPUs del core, pero, poco a poco, esta naciente plataforma estaba evolucionando a Nvidia de una compañía de diseño de GPUs para videojuegos, a una compañía que por medio de CUDA, estaba creando un naciente ecosistema hardware/software, a su ritmo, y sin planearlo, desarrollaba un mercado en el que el cómputo paralelo cada vez era más relevante para procesar información.

Por la vía de CUDA, Nvidia inicia una arquitectura abierta, jalada por los clientes, quienes aceleraron la entrada a los desafíos computacionales más exigentes de la última década: la nube y el bitcoin. Esto disparó a Nvidia, poniéndola en la ruta del trillón de dólares.

El Juego Infinito

Emergentemente, por medio de CUDA como eje de este ecosistema naciente, se haría explícito el nuevo estándar para el aprendizaje automático en el procesamiento de datos, que años después se convertiría en la base esencial para el entrenamiento, creación y evolución de modelos de inteligencia artificial cada vez más masivos, como los que ahora se han hecho mundialmente famosos gracias a ChatGPT.

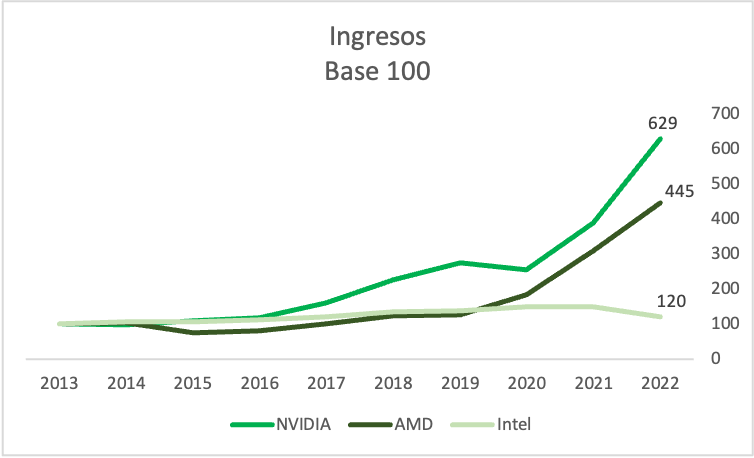

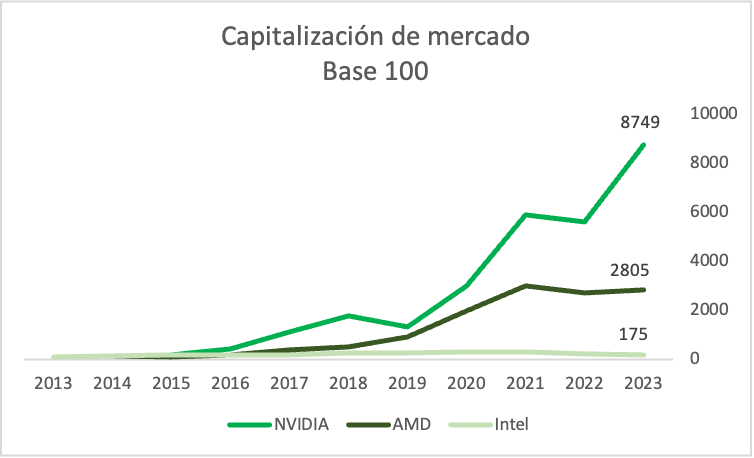

En efecto, en 2023, cuando GPT-3.5, más conocido como ChatGPT, fue presentado al mundo, la emoción detrás de la inteligencia artificial generativa explotó. Se volvió imposible para cualquier organización no hablar, pensar, o preocuparse por los poderes que estos modelos de IA habían alcanzado. ChatGPT se convirtió en la aplicación de crecimiento más rápido de todos los tiempos.

Fue entonces cuando en el mercado se creó conciencia rápidamente de quién había hecho la orquestación que derivó en todos estos nuevos desarrollos: Nvidia. Debido a la amplia presencia del ecosistema CUDA, y al simple hecho de que CUDA, combinado con el hardware de Nvidia, era muy superior a cualquier otra alternativa de cómputo paralelo en el mercado, cada uno de los principales modelos de IA había sido entrenado con el hardware de Nvidia, utilizando CUDA.

Simplemente no había forma de competir en el mundo de la IA sin aprovechar el ecosistema de Nvidia. La demanda de su hardware es tan alta que el problema de la compañía ahora radica en escalar sus operaciones para satisfacer la demanda del mercado: la lista de espera para obtener su GPU insignia —H100 Tensor Core— tiene un tiempo de entrega de mínimo seis meses, y la mayoría de sus líneas de producción ya están reservadas por los actores más importantes del mundo de la tecnología. En la nueva era que creó la IA, se encontró una mina, y Nvidia era la única que vendía la pica y la pala.

Una compañía que reina sobre la nube, las criptomonedas, los videojuegos, la realidad aumentada, las tecnologías autónomas y ahora sobre la inteligencia artificial; que lo hace desde el software, a pesar de que produce hardware, y con un modelo fabless (sin fábricas propias), lleva a pensar que va a ser la compañía más valiosa del mundo y que está condenada al éxito.

Lo primero seguramente ocurrirá en los próximos 3-5 años. Sin embargo, en lo segundo, en el juego infinito de la Estrategia Emergente es imposible: se puede decir “estoy ganando”, pero nunca se puede decir “ya gané”, pues no hay victoria eterna en estrategia. Huang y su equipo no podrán dormirse en los laureles, que en lengua de Estrategia Emergente significa mantenerse muy consciente de su actuar, y especialmente del choque con el mercado, y practicantes del “hard choice” que, como lo entendemos, hace que una organización nueva emerja cada cierto tiempo de la interacción con el mercado. Eso, claro, sólo si en 10 años quiere seguir ganando y mantenerse en la élite de la riqueza.

Lecciones de Estrategia Emergente de esta Historia

Para ganar en grande hay que dominar un segmento.

Los “hard choices” son mutaciones en la organización. Nvidia es paralela tanto como sus chips.

El crecimiento rentable lo desata la acumulación de capacidades distintivas concentradas en dirección de la ventaja.

El foco nunca limita oportunidades: las expande.

Las teorías de negocio envejecen mejor que los planes.

Estrategia es organización. La destrucción creativa del capitalismo elimina organizaciones perdedoras y recicla el talento en organizaciones ganadoras.

Acabamos de abrir inscripciones para el Bootcamp de La Estrategia Emergente 2024. Conozca todo sobre este evento e inscriba a su compañía. Sólo hay 20 cupos.